|

|

|

del Sitio Web Erraticario

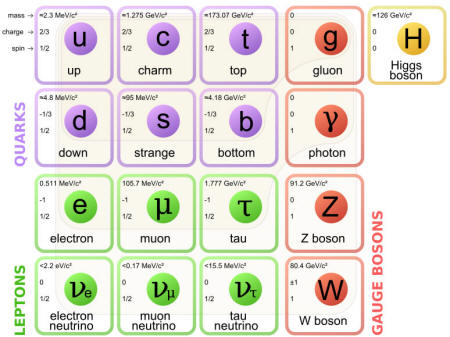

En un artículo publicado en la revista Scientific American en agosto de 2013 (y en su versión española Investigación y Ciencia, en octubre), el filósofo Meinard Kuhlmann cometió la osadía de cuestionar la visión que de la realidad ofrece el modelo estándar de la física de partículas.

Aparentemente, el modelo estándar parece bastante claro:

En términos de precisión empírica, la teoría quántica de campos es la teoría que más éxitos ha cosechado en la historia de la ciencia.

Se usa para sacar conclusiones de los datos obtenidos en los aceleradores de partículas, para entender los primeros sucesos ocurridos tras el Big Bang o para averiguar qué ocurre en el interior de los núcleos atómicos.

Y, sin embargo, dice Kuhlmann que la teoría quántica de campos, el marco de referencia sobre el que se construye dicho modelo estándar, podrá describir con todo el éxito que se quiera las partículas y sus interacciones en campos de fuerza, pero que, en realidad, nadie sabe de qué está hablando.

Según el filósofo de la Universidad de Bielefeld, en Alemania, pocos se atreven a enfrentarse a la teoría de campos con la suficiente profundidad para aportar algo más que un simple conocimiento utilitario, una actitud que frena los avances hacia el descubrimiento de cualquiera que sea la física que subyace al modelo estándar, más allá del cual todo se considera profanación de la razón:

Porque, con todo, el modelo estándar es incompleto y exige una física más amplia que lo integre; no explica cuestiones tan fundamentales como la fuerza de la gravedad o la materia y energía oscuras, las cuales supuestamente son el ingrediente de los que está hecho el 96% del Universo.

Tampoco puede dar cuenta de algo esencial - lo esencial siempre es lo más complicado - para entender el universo: ¿por qué hay materia?

Según el modelo estándar, materia y antimateria se produjeron a partes iguales; de haberse conservado la simetría, en este universo sólo habría fotones, que es lo que queda cuando una partícula de materia se encuentra con otra de antimateria y, debido a tal encuentro, se aniquilan la una a la otra.

Una de las aspirantes a ese marco en que insertar la pequeña parte que es el modelo estándar es la supersimetría, que predice la existencia de partículas asociadas a cada una de las "oficialmente" existentes, pero mucho más pesadas que sus compañeras conocidas.

Estas partículas podrían explicar asuntos no resueltos como la materia oscura y, además, incluye escenarios que hacen posible la asimetría entre materia y antimateria.

El problema es que aún no se ha detectado una sola de estas partículas supersimétricas. Las esperanzas están puestas en 2015, año en que se espera que el acelerador de partículas del CERN alcance su máximo rendimiento.

Como explican los físicos Joseph Lykken y María Spiropulu en un artículo al respecto aparecido en la revista Investigación y Ciencia en junio de este año, el futuro de la Física depende de lo que ocurra entonces:

Pero, mientras el mayor acelerador de partículas del planeta se prepara para rendir al máximo y los físicos de partículas se ponen las pilas, nosotros, pobres mortales, seguimos a vueltas con la distinción entre campo y partícula, que se antoja tan artificial cuando se aborda en detalle que poco puede decirnos de las cosas últimas de la existencia.

Así pareció entenderlo Albert Einstein cuando sugirió, en The Evolution of Physics (1938), que la diferencia entre campo de energía y materia es ficticia; esto significa que ni materia ni campo son el constituyente último de la realidad, pues ambas son manifestaciones de un mismo fenómeno que se nos aparece bajo dos formas diferentes pero que no puede ser ninguna de ellas, y cuya unidad trasciende la supuesta dualidad masa-energía.

Los campos de energía están quantizados, o "particularizados", que es lo que permite hablar de fotones y demás bosones que llevan la fuerza de un lugar a otro, como se explica unos párrafos más adelante en este artículo; y, según convenga, unas veces el campo prevalece frente a la partícula y otras la partícula determina el campo.

Todo lo cual parece dejar claro que las entidades básicas de la realidad no son ni una cosa ni la otra.

A pesar de la fe en la partícula, las unidades elementales de la materia no se comportan como minúsculas bolas de billar por mucho que tal sea la noción que aún se tiene o, por lo menos, con la que se vive en la rutina del día a día. El concepto clásico de partícula implica algo que existe en una lugar concreto.

Pero las localizaciones concretas no existen en el mundo quántico, que es precisa y paradójicamente el reino donde habitan las "partículas".

Y si la concreción es una cuestión relativa, el vacío también. En física quántica, el vacío se entiende como la interacción de partículas y antipartículas que da como resultado fluctuaciones de medida nula; se anulan unas a otras. Es decir, el vacío no está vacío y por ello es posible que de él derive la energía y la materia.

Así lo explica el físico Leonard Susskind en su libro El paisaje cósmico:

En resumen y en términos consuetudinarios, que, según todo lo dicho, las partículas no pueden estar donde se supone que están y, en idéntica contradicción, pueden estar donde se supone que no están.

Así que, si no hay partículas como tales, ¿qué es lo que detectan los aceleradores de partículas?

La respuesta es que toda partícula detectada es, en términos precisos, una inferencia: el detector registra excitaciones en el sensor y tales excitaciones son agrupadas en trayectorias y asociadas bajo el concepto de partícula.

Es decir, la partícula vendría a ser algo así como una agrupación de cualidades independientes, y toma forma por acto creativo y no constitutivo.

Tampoco queda claro qué es un campo desde una perspectiva quántica.

En física clásica, se trata de una región sometida a una "influencia invisible", que dice Susskind en el libro antes citado.

El modelo estándar asocia tal influencia "invisible" a la acción de partículas portadoras o mensajeras llamadas bosones, como se ha resumido al comienzo de este artículo:

...faltando al día de hoy la partícula portadora de la gravedad, de la cual no se tiene noticia alguna.

Y estos bosones van de unos fermiones a otros, que es como se conoce a las partículas de materia como los quarks y los electrones, estableciendo sus relaciones de atracción o repulsión.

Volvamos a resumir: un campo de fuerza es la manifestación de partículas que interactúan, pero las partículas no existen, al menos no son lo que damos por hecho que son; así que… ¿qué demonios es un campo de fuerza?

En el mundo clásico, el campo aporta magnitudes concretas a un punto del espacio-tiempo y permite visualizar, por ejemplo, una trayectoria o la manera en que se propaga una onda. Sería como un mapa del tiempo donde hay un indicativo de temperaturas y presiones para cada zona del mismo.

En el mundo quántico, sin embargo, nos explica Kuhlmann, el campo proporciona datos referidos a cualidades abstractas que también se expresan en fórmulas matemáticas, pero que no pueden relacionarse con algo físico y que más que un mapa parecen instrucciones de uso para configurar el mapa.

Desde la perspectiva ontológica, dice Kuhlmann, no puede ser satisfactorio que nos conformemos con la explicación del mundo a partir de una fase de la realidad, donde ya existen las partículas y los campos, que dista mucho de aproximarse siquiera a los fundamentos a que ha llegado la ciencia misma en la descripción de esa realidad.

Kuhlmann parece decantarse por lo que se denomina "realismo estructural", según el cual no podemos conocer la naturaleza real de las cosas, sino cómo se relacionan unas entidades con otras. La estructura del mundo, sus relaciones, es, al fin y al cabo, lo que permanece tras el desgaste de las teorías que se suceden unas a otras intentando explicar qué es la realidad.

Por ejemplo, tomemos las teorías surgidas en torno al concepto de gravedad, tal y como la explica la periodista y divulgadora Amanda Gefter en su libro Trespassing Einstein's Lawn: aunque la teoría de Newton parece incompatible con la de Einstein, la primera no es sino la aplicación de una misma estructura matemática a los estados más bajos de energía descritos por la teoría de Einstein, es decir, la de Newton describe el límite inferior de la Teoría General de la Relatividad.

La de Einstein incluye la de Newton y, por descontado, se incluirá a su vez en una teoría más amplia.

Ahora bien, ¿cuál es la razón por la que sólo es posible conocer la estructura del mundo y no el mundo en sí mismo? La respuesta más directa es afirmar que las relaciones son lo único que existe; luego, la mente humana construye las historias en torno a estas relaciones.

John Worrall, padre del realismo estructural, no va tan lejos; para él, es una cuestión epistemológica, no ontológica: si existen relaciones, existen elementos que relacionar. Pero hay otra vertiente más radical, el realismo estructural óntico, que considera que las relaciones son una cuestión puramente matemática: no hay objetos.

Los defensores de tal idea consideran que es posible construir una teoría válida proponiendo la existencia de relaciones específicas sin que sea necesario asumir la existencia de objetos concretos; y que, de hecho, prescindir de las entidades evita la distracción que contamina el estudio de la realidad con aspectos secundarios.

Cualquier ejemplo basado en redes sirve para acercarnos a qué quieren decir; así, podemos pensar en estos filósofos como viajeros de metro a quienes no interesa conocer la localización física de las estaciones, la cercanía, pues no se trata de cuál está más cerca, sino de cómo están conectadas unas con otras.

Todo lo demás es secundario.

Según esta consideración de que la estructura es la base de la realidad, anterior al objeto en sí, resulta extraño pensar que puedan existir relaciones sin cosas que relacionar.

Sin embargo, cualquiera que eche un rápido vistazo a la historia de la filosofía, observará que esta idea de que la información prevalece a lo informado no es una gran novedad de nuestros tiempos; tiempos en los que, por otra parte, cabe destacar el trabajo de Vlatko Vedral para determinar en el ámbito de la física cómo es que la información se puede considerar el principio de todo.

En su libro Decodificando la realidad, Vedral considera que, antes de que el universo se materialice, debe existir en un estado ontológico, una realidad metafísica con la información para generar la realidad física; esa información incluye la creación de seres conscientes capaces de interpretarla, en un proceso retroactivo.

La conciencia humana evoluciona con el universo, pero el universo también evoluciona según la conciencia descubre más cosas sobre sí misma.

La realidad es, desde esta perspectiva, la información que tenemos para comprender el universo y que determina lo que es posible y lo que no; y dicha realidad cambia en función de la información disponible.

La información es, en términos de Vedral, el conjunto de enlaces entre las partes de un sistema para crear una complejidad coherente; aquello que impide describir un sistema como la suma de sus partes, pues cada una de estas partes, tomadas por sí solas, no explican la totalidad.

Las teorías actuales acerca de la información mantienen que ésta es el único concepto que se puede explicar como creador de sí mismo, como el principio último que busca la física, el origen de todo incluyendo el origen, el principio fundamental, pues si no se incluyera a sí mismo habría que buscar más allá y dejaría de ser origen.

En una reseña del libro Cerebro y Universo, dos cosmologías, del físico y poeta David Jou, leemos:

A veces, es posible para la mente humana crear una imagen figurada que aglutine la información aprehendida; otras, en cambio, los datos se quedan en un nivel más abstracto o no pueden ser "descodificados".

Esta capacidad, en matemáticas, es la distancia que percibimos entre álgebra y geometría: el álgebra se refiere a la misma realidad que la geometría, sólo cambia la forma de representar dicha realidad; mientras que en geometría se visualizan los cuerpos, en álgebra esos mismos objetos están representados por abstracciones llamadas funciones, y unas reglas por las que las funciones se relacionan unas con otras.

La geometría está limitada por nuestra capacidad para visualizar la realidad. Así, hay un momento en que el álgebra es capaz de ir más allá de la geometría conocida, de manera que tenemos la función algebraica pero no somos capaces de representar la forma espacial, geométrica, a que se refiere.

Cuando accedemos al mundo quántico, topamos con un álgebra no conmutativa por el que se describen espacios diferentes que ya no caben en un eje de coordenadas al uso, sino que entran a formar parte de una función de onda descrita por operadores, los sustitutos de las coordenadas.

Hay un espacio ajeno al que conocemos. O quizás debamos decir un "no-espacio". Quienes pretendan comprender tales regiones de la realidad no pueden confiar en la experiencia, sino en la intuición escondida tras el álgebra abstracta de donde nunca saldrán certezas, sino probabilidades.

Volvemos al artículo sobre Jou:

Todo proceso cósmico se reduce a un intercambio binario entre partículas: sí o no. 1 o 0.

Según Ed Fredkin, científico del M.I.T., si se consigue profundizar en este proceso, acabaremos descubriendo que el universo sigue una única ley, y ésta ley, en términos de computación, sería "si x, entonces y".

Esta es la rutina por la que el lenguaje informático manipula los bits contenidos en un transistor para controlar las diferentes salidas lógicas.

La rutina "si x, entonces y" es el principio de información considerada "mecánica" a que se refiere Jou, surgida de relaciones y, por tanto, posteriores a cualquier origen. Si traspasamos la lógica mecánica del transistor, el universo adquiere una textura resumida en los postulados de la física quántica. En ella, las cosas no se complican; tampoco se simplifican. En realidad, se superponen.

El principio de superposición nos dice que, antes de ser energía o materia, la realidad es una onda de probabilidad que contiene todos los valores posibles, es decir, que todo es información en estado latente. Sólo cuando se producen interacciones dicha información se manifiesta como energía y materia.

Y mientras haya superposición, no hay relaciones pues no hay nada con qué relacionarse en ese "Todo" donde la información aún no ha sido manifestada en forma de paquetes de energía o partículas.

Si vamos al fondo del asunto, las leyes de la física y cualquier fórmula matemática se reducen a algo tan simple como incomprensible: 0=0. Aquí comienza todo. Según la teoría de conjuntos, todas las estructuras matemáticas surgen de esta idea denominada conjunto vacío, 0. Se puede definir 1 como el conjunto que contiene al conjunto vacío, 2 como el conjunto que contiene los conjuntos 0 y 1, 3 como el conjunto que contiene los conjuntos 0, 1 y 2, etc.

Pero démosle la vuelta. Pensemos en el conjunto vacío no como contenido sino como continente. No la Nada que se propaga - ¿hacia dónde se propaga la Nada si la Nada lo es Todo? - sino la Nada que se divide en sí misma y en la cual se desarrolla Todo.

Divisiones que comienzan relaciones y relaciones que se estructuran en un proceso de vuelta a algún tipo de unidad perdida, que dirían los más místicos.

Relaciones sin objetos…

Una idea ésta que se esconde bajo diferentes formas y vestidos en las diversas filosofías que se han atrevido a abordar el tema de la Nada - y el Infinito, por otra parte - en relación al origen y destino del universo en general y del ser humano en particular, y que ahora se asoma divertida a las puertas del templo donde se guardan, bajo custodia, los paradigmas científicos del hombre moderno.

Sin embargo, y aunque todo resultara cierto, parece que aún fuese pronto para cruzar el umbral.

|