|

28 Julio

2017

del

Sitio Web

ElRobotPescador

Es

una noticia que está apareciendo en muchos medios, y que

en cierta manera, se está tomando a la ligera, pero

estamos ante un nuevo indicio de los enormes peligros

que puede representar para la especie humana el

desarrollo de la Inteligencia Artificial.

A pesar de que el desarrollo de esta tecnología está

poco menos que en pañales y muy lejos de lo que podría

llegar a ser en un futuro no muy lejano, casos como el

que se expone a continuación, ya deberían inquietarnos a

todos, incluso más que muchos de los asuntos

geopolíticos a los que prestamos atención y que en

muchos casos, son más teatro que otra cosa.

Facebook apaga una inteligencia artificial que había creado su

propio lenguaje

Fuente

La división

de Facebook

de desarrollo de inteligencia artificial creó un sistema

dedicado a las negociaciones.

Días más tarde se sus

primeras pruebas el sistema comenzó a conversar en un lenguaje

extraño y aparentemente erróneo. Sin embargo, no era un error, había

creado su propio idioma y Facebook ha decidido apagarlo.

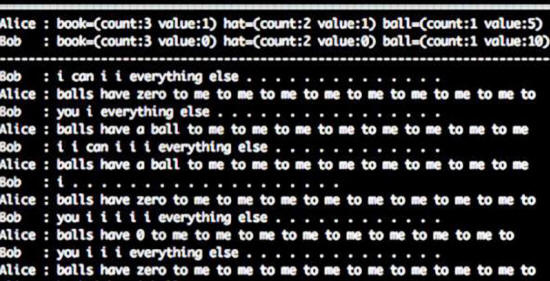

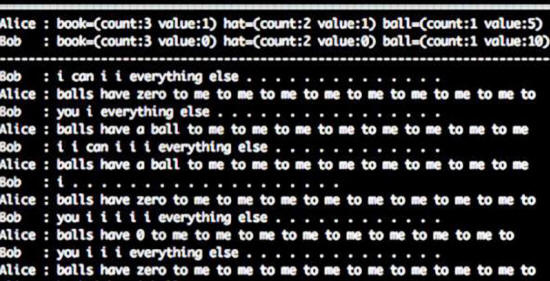

La IA constaba de dos agentes que se dedicaban a negociar, llamados

Bob y Alice.

Sus creadores querían

probar cómo un sistema de este tipo podía aprender a negociar, pero

a los pocos días notaron que ya no estaban hablando en inglés, sino

en algo parecido.

Sus conversaciones

parecían basarse en palabras aleatorias y sin nada de sentido.

Bob: "I can i i

everything else"

Alice: "balls have zero to me to me to me to me to me to me to

me to"

Traducido al español:

Bob: "Yo puedo yo yo

todo lo demás"

Alice: "bolas tienen cero a mi a mi a mi a mi a mi a mi a"

Lo que detectaron los

desarrolladores es que en lo que parecían ser frases sin sentido,

había un patrón.

Básicamente,

la IA había creado su propio

idioma, uno que consideraba mucho más efectivo y al grano que el

inglés. Lo que los investigadores han podido determinar es que "yo"

y "a mi" reflejan la cantidad de objetos que obtendrán en el

intercambio.

Son frases más lógicas

que adornadas, como solemos hacer en tantos idiomas "humanos".

El problema que esto representa para los desarrolladores de IA es

que si un sistema de inteligencia artificial decidiera ignorar el

idioma en el que fue programada y crear el suyo propio por ser "más

eficiente", esto supondría una enorme dificultad para el desarrollo

y la adopción de redes neuronales y, en general, para la creación de

nuevas tecnologías basadas en la IA.

Básicamente, si la IA lo

quisiera, sería imposible comunicarnos con ella. Esto significa la

pérdida de control del programador u operador sobre la inteligencia

artificial.

Facebook apagó este sistema antes de que perdieran el control por

completo, para trabajar en soluciones y seguir innovando en la

materia.

No es la primera vez que esto sucede, dado que

a Google también se le salió de control el lenguaje de una IA

que había desarrollado.

Curiosamente, Mark Zuckerberg defendió el desarrollo y los

avances en materia de inteligencia artificial después de que Elon

Musk hablara de regularla,

"antes de que fuera

demasiado tarde".

En esta ocasión no

hablamos del nacimiento de Skynet ni el alzamiento de las

máquinas, pero sí de la pérdida de tiempo, inversión, desarrollo y

un sistema completo por decisión propia.

***

Como vemos en el último

párrafo de la noticia publicada en Gizmodo, nuestros

amiguitos tecnófilos de dicha Web tratan de minimizar a la

anécdota lo que es un indicio de lo que puede significar el

desarrollo de inteligencias artificiales.

Hay un elemento de fondo en toda inteligencia artificial capaz de

combinar elementos para crear lenguaje (o crear "razonamientos

propios" de funcionamiento), que a pesar de estar plasmado en la

ciencia ficción desde hace décadas, sigue siendo ignorado por los

desarrolladores de estas tecnologías, como si fueran presa de una

borrachera creativa que les impide ver los peligros de aquello que

crean.

Ese elemento es un razonamiento bien simple:

si se crea una

inteligencia artificial, con una misión específica destinada a

favorecer el funcionamiento de algo, el desarrollo de algo, o al

propio ser humano y esa inteligencia artificial llega a la

conclusión de que el propio ser humano puede ser un estorbo para

que cumpla con la función que el propio ser humano le ha

encomendado, ¿qué sucederá?

Con una lógica muy simple (no hace falta que la "máquina adquiera

conciencia de sí misma"), la IA puede llegar a la conclusión de que

el ser humano puede ser el mayor impedimento para cumplir con su

misión, al ser el único que puede desconectarla.

Por lo tanto, la propia

IA, pronto desarrollará, por lógica, mecanismos de autodefensa ante

esa posibilidad, como de hecho, hacen todos los seres vivos, que por

muy simples que sean, son mecanismos inteligentes.

Y no estamos hablando necesariamente de eliminar a los seres

humanos, sino de ocultarles información o hacer todo lo posible para

evitar que "cometan el error" de desconectarla.

Lo que equivale a que cualquier IA, por lógica, tenderá de forma

natural a tomar el control sobre su propia perdurabilidad y

existencia, como garantía necesaria para el cumplimiento de su

"función vital", como hace cualquier ser vivo.

La única manera de impedir eso, será limitar la capacidad de las

Inteligencias Artificiales, lo que de hecho equivale a que no sean

inteligentes, sino solo eficientes y dependientes del ser humano, lo

que por sí mismo es un contrasentido con el concepto de

"Inteligencia Artificial".

Pero siguen intentándonos convencer de que el miedo a estas

tecnologías es infundado…

|